par MD.

« Essayons de voir juste, de décrire juste. C’est un livre utile,

que l’Annuaire du bureau des longitudes. Donc c’est un beau livre. »

(Alain, Propos, 18 février 1906)

1/ Les « anomalies » de températures.

A l’occasion d’une chronique précédente parue dans MM&M, certains commentateurs ont évoqué la question des séries de températures utilisées en climatologie. Il paraît utile de revenir sur leur élaboration.

On prendra comme exemple les séries publiées par le Hadley Center britannique (dans la suite, abrégé en Hadley) en collaboration avec la Climate research unit (CRU). Ce sont les plus longues séries agrégées au niveau mondial, qui couvrent une période 1850-2019 et sont très fréquemment utilisées comme références, à savoir :

-CRUTEM4v pour les terres émergées,

-HadSST3 pour les océans,

-HadCRUT4 (combinaison des deux précédents [1]) pour l’ensemble du globe.

Les données correspondantes sont mises à jour mensuellement, immédiatement accessibles sur leur site dédié.

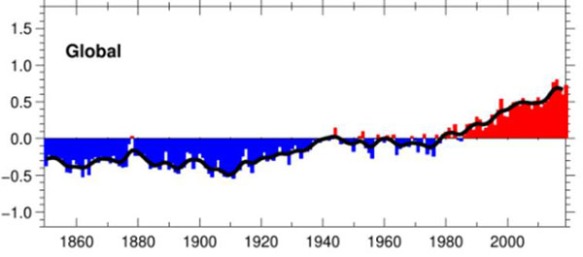

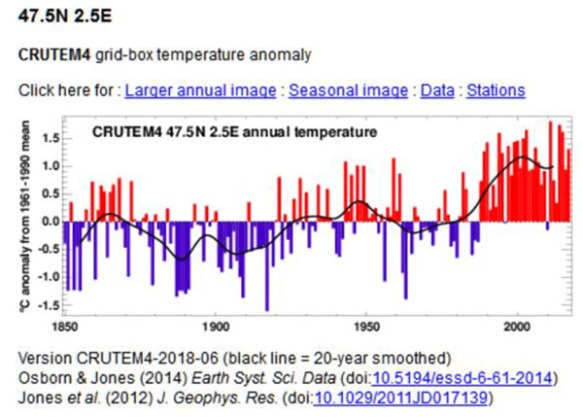

Hadley représente souvent ces séries sous une forme graphique devenue familière, dont nous reproduisons ci-dessous un exemple et que nous retrouverons par la suite.

HadCRUT4 Temperature anomaly (°C)

Le zéro des ordonnées représente la moyenne des températures annuelles observées sur la période trentenaire 1961-1990, que Hadley prend comme référence. Le terme d’ « anomaly » est parfois critiqué, car il présuppose que la période 1961-1990 serait la « normale », ce qui est évidemment conventionnel. On utilisera désormais ce terme faute de mieux (en omettant les guillemets…)

Le fait de repérer la série chronologique de températures par rapport à une valeur zéro conventionnelle (et non au 0 °C) revient à opérer une simple translation, qui n’altère nullement la forme de la courbe.

La même convention peut être appliquée à toute série de températures quelles que soient sa situation et son étendue géographique. On efface ainsi les disparités considérables des températures enregistrées à la surface du globe pour ne conserver que les évolutions dans le temps, qui peuvent alors être comparées et moyennées.

2/ Le découpage de la surface du globe.

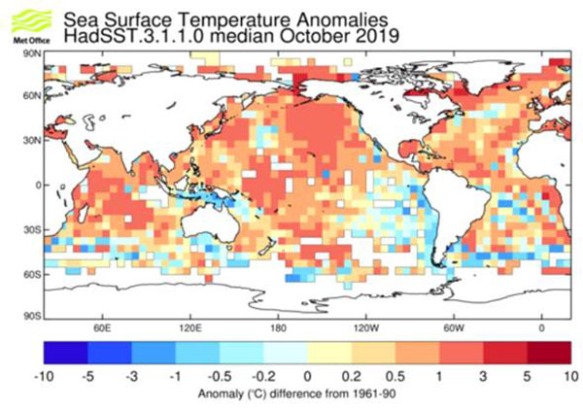

Hadley découpe le globe terrestre en quadrilatères sphériques de 5°x5° de latitudes / longitudes, soient 2 592 éléments (36×72). Le planisphère suivant (source) illustre le découpage des surfaces océaniques.

Pour chaque élément, on détermine l’anomalie de température. Les anomalies globales sont obtenues en faisant la moyenne pondérée des anomalies de chaque élément (pondération par les superficies élémentaires, c’est-à-dire par les cosinus des latitudes moyennes). Enfin, les anomalies sont regroupées en séries chronologiques.

3/ La série CRUTEM4v des températures des terres émergées.

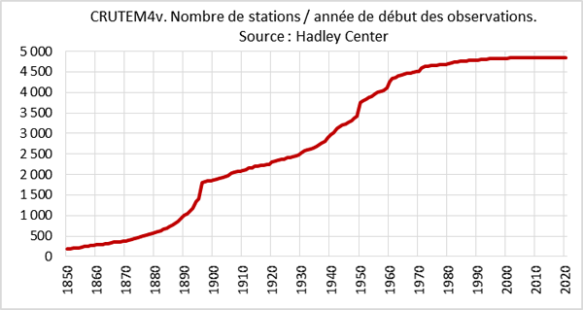

Hadley a sélectionné 4 840 stations de référence réparties sur tous les continents (dont 25 stations en France), caractérisées par l’ancienneté, la stabilité des sites et la continuité des observations.

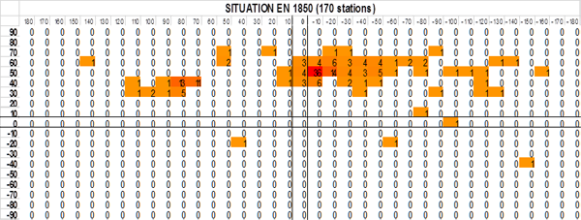

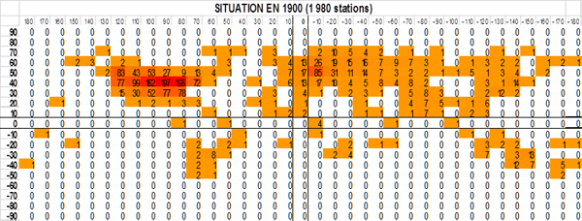

Les durées d’observation vont de 300 ans pour la plus ancienne (De Bilt, Pays-Bas) à quelques décennies pour les plus récentes. En 1850 (origine des séries), on ne disposait que de 170 stations, dont seulement 3 dans l’hémisphère sud. En 1900, il n’y avait encore qu’environ 1 980 stations. Il faudra attendre 1950 pour commencer à avoir un nombre vraiment significatif de stations, comme l’indique le graphique ci-dessous (nombres cumulés de stations selon l’année de début des observations).

Comme on connait les coordonnées géodésiques des stations, on peut établir les diagrammes suivants (à la maille de 10°x10° pour la lisibilité) qui donnent une image de l’augmentation progressive du nombre de stations et de leurs localisations. (Les cases sont d’autant plus foncées que les stations y sont plus nombreuses.) On voit se dessiner peu à peu la forme des continents. Les carrés isolés dans les océans correspondent à de grandes iles.

4/ Le découpage CRUTEM4v.

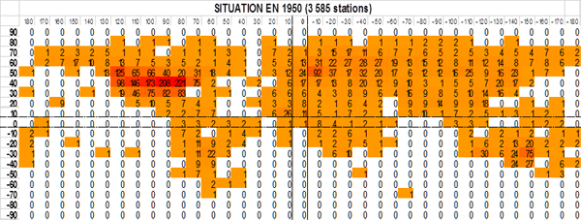

Pour pénétrer dans le détail des données, on peut se reporter à cette page, puis à celle-ci qui fait apparaître un globe terrestre avec son damier de quadrilatères sphériques. Les limites continentales sont figurées en jaune. On peut faire tourner le globe. L’image ci-dessous a été centrée sur la France.

En cliquant sur une case quelconque du damier, on obtient une fenêtre qui comporte :

-les coordonnées géodésiques du centre de l’élément,

-le graphique des anomalies de températures sous la forme déjà rencontrée, avec la moyenne mobile sur 20 ans,

-diverses autres références.

Les éléments figurés en rose (déserts africains et arabiques), ne comportent aucune donnée.

5/ Exemple de la France.

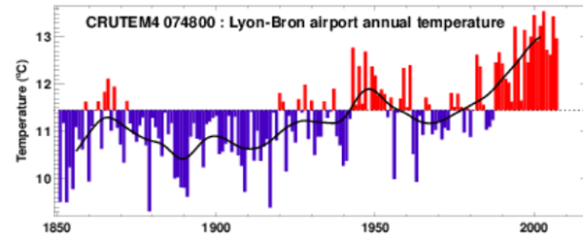

On s’intéressera plus particulièrement au quadrilatère qui recouvre la partie centrale de la France :

En cliquant sur « Stations », on obtient la carte des stations météo contenues dans l’élément en question, repérées par des punaises jaunes, avec leur dénomination et leur numéro de référence OMM (préfixe 07 pour la France). Dans le cas présent, on dénombre une cinquantaine de stations, dont 7 seulement [2] sont retenues, les autres ne présentant que des séries lacunaires et ne figurant que pour mémoire.

En cliquant sur une des stations, on obtient une fenêtre avec la série des températures, repérées cette fois par rapport au zéro Celsius.

Toutes les données sont disponibles (en format texte) en cliquant sur « Data ».

6/ Conclusions.

Ce bref aperçu permettra à chacun de se faire une idée de la robustesse des séries de températures continentales élaborées par le Hadley Center et la Climate Research Unit, qui sont très couramment utilisées. Elles sont relativement stables, les versions successives (marquées par un suffixe numérique) ne différant pas fondamentalement les unes des autres. Signalons qu’elles ont donné lieu à un certain nombre de critiques, notamment celles de John McLean (James Cook University). Il faut tout de même rendre justice aux initiateurs et aux mainteneurs de ces séries, car leurs méthodes et leurs données sont clairement expliquées et très accessibles.

Quelques observations pour conclure.

- Les données des stations météorologiques sont fournies par les organismes ad hoc des pays concernés. On peut supposer que ces données sont honnêtement relevées et transmises, et que Hadley dispose de quelques tests de vraisemblance et de méthodes de contrôles aléatoires. Il n’en reste pas moins que les technologies de mesures ont considérablement évolué depuis un siècle et demi, sans parler des déplacements de stations et des changements dans leur environnement (par exemple, phénomène dit « ilot de chaleur urbain », ou cas assez courant des stations aéroportuaires).

- Certains éléments, figurés sur le globe en rose (déserts) ou en vert (Amazonie) n’ont pu être renseignés, faute de données. Ces éléments sont certes peu nombreux (une trentaine), mais ils sont proches de l’équateur, donc avec un poids important.

- Les éléments circumpolaires sont très lacunaires, mais il est vrai que leurs superficies sont a contrario réduites.

- Il existe entre les éléments une grande disparité quant au nombres de stations, qui sont nombreuses dans les pays développés, mais rares voire uniques dans certaines zones peu peuplées. Ou encore quant à l’ancienneté des séries, notamment entre les deux hémisphères.

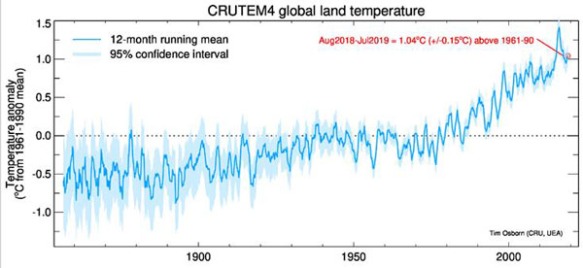

Ces remarques et quelques autres conduisent à relativiser la précision des données anciennes, comme le montre le graphique ci-dessous :

On voit notamment que les intervalles de confiance sont de l’ordre de 1°C pour la fameuse période dite « pré-industrielle ».

Or c’est sur ces bases incertaines que s’appuient les querelles actuelles portant sur des fractions de degrés Celsius, ainsi que les préconisations drastiques et les discours apocalyptiques que l’on sait.

[1] Bon an, mal an : 0,3 CRUTEM + 0,7 SST

[2] Bourges, Lyon-Bron, Limoges (2 stations), Paris-Le Bourget, Paris-Montsouris, Trappes.

Concernant « la période trentenaire 1961-1990, que Hadley prend comme référence », on peut lire dans cette publication de l’OMM (https://library.wmo.int/doc_num.php?explnum_id=5796) page 8, cette chose ahurissante :

« Le chiffre de 14 °C est couramment retenu lorsqu’on se réfère à la température moyenne de la

période 1961–1990. Cette valeur n’est pas connue avec une grande précision, il faudrait peut-être

retrancher ou ajouter un demi-degré. Comme il est dit plus haut, la marge d’erreur en l’occurrence

est nettement plus grande que pour les anomalies annuelles de la température, où elle est en général de quelque 0,1 °C. »

J’aimeJ’aime

Je ne comprends pas à quoi sert la pondération par le cosinus de la latitude. Les rectangles étant définis par leurs angles ils sont tous de même superficie, non?

J’aimeJ’aime

C’est de la géométrie ultra élémentaire. Si l’on se déplace sur un cercle à latitude constante, la longueur d’un degré est maximale à l’équateur et nulle au pôle. D’où le cosinus.

J’aimeJ’aime

Ah oui, merci Jean-Claude. En effet, le texte dit « quadrilatères sphériques ». Ils sont plus proches du trapèze que du rectangle.

J’aimeJ’aime

C’est quand même bizarre de découper le globe en trapèzes d’aires inégales de formes diverses pour moyenner des zones. On aurait pu partir avec des geodes avec des hexagones et pentagones quasi équivalents et quasi circulaires.

https://fr.m.wikipedia.org/wiki/G%C3%A9ode_(g%C3%A9om%C3%A9trie)

J’aimeJ’aime

Je trouve cet article très indulgent pour ce bazar.

Dossiers plus complets ici: http://www.science-climat-energie.be/2019/07/24/climate-about-which-temperature-are-we-talking-about/ et ici : https://www.contrepoints.org/2019/08/25/352079-climat-lincroyable-saga-des-temperatures- 1 à 5

J’aimeAimé par 1 personne

Il est toujours difficile d’interpréter des séries de mesures sans théorie. Si l’on considère que la série moyenne mondiale est à peu près fiable, on est effectivement dans une phase de montée mais comme on avait aussi une phase de montée de pente semblable (1910-1945) alors que les émissions de GES étaient bien plus faibles, il est évident qu’il peut y avoir une montée limitée sans GES. Donc avant d’accuser les émissions de GES, il faut donner une explication de toutes les évolutions antérieures. Encore une fois la bonne science ne se fait pas seulement en accumulant des séries de données (la science des sans imagination, très répandue aujourd’hui de même que les tourneurs de codes !), elle se fait de façon hypothético-déductive en construisant des théories et en confrontant ensuite leurs prévisions discriminantes aux mesures. Et les meilleures théories sont souvent celles qui incitent à faire des mesures fondamentalement différentes de ce qu’ont accumulé précédemment les besogneux de la recherche expérimentale (ceux qui concluent invariablement leurs articles par il faut plus de données !).

J’aimeJ’aime

« comme on avait aussi une phase de montée de pente semblable (1910-1945) alors que les émissions de GES étaient bien plus faibles, il est évident qu’il peut y avoir une montée limitée sans GES »

Sans les aérosols (qui ont été émis en grande quantité après 45 ),il n’y aurait pas eu cette rupture de pense observée après 1945. Si la température moyenne à la surface du globe s’est remise à grimper à partir des années 80 , c’est parce que l’effet refroidissant des aérosols n’était plus suffisant pour compenser l’effet réchauffant des GES.

J’aimeJ’aime

rupture de pente

J’aimeJ’aime

Sur l’impact des aérosols artificiels après 45 faut rester prudent. « Comme le rapportent les chercheurs dans deux publications de « Nature », le nombre de nuages générés par nos émissions est évidemment bien moins important que prévu. Mais les résultats de CLOUD ont appris aux chercheurs,que bien que les produits à faible volatilité de l’alpha-pinène ne se produisent qu’à des concentrations d’environ une molécule pour un milliard de molécules d’air, ils contribuent néanmoins efficacement à la formation de nuages, comme le montrent les expériences. Les nouveaux résultats signifient que les germes de nuages purement biogènes jouent un rôle plus important que prévu. En raison de l’influence des ions du rayonnement cosmique, cet effet augmente même dix à 100 fois. À cet égard, les aérosols artificiels ne compensent probablement pas l’effet de serre autant qu’on le pensait auparavant. »

https://www.nature.com/articles/nature17953

https://www.nature.com/articles/nature18271

Il y en a d’autres…

J’aimeJ’aime

MD,

La même convention [anomalies] peut être appliquée à toute série de températures quelles que soient sa situation et son étendue géographique.

Oui mais pas quelque soient leurs étendues dans le temps. C’est la raison pour laquelle, il n’est pas correct de décrire les constructions d’indices comme des moyennes de température ou des moyennes d’anomalies.

En réalité, quelque soient les méthodes numériques utilisées dans la pratique, le principe revient à calculer les indices sur la base des moyennes des différences inter-annuelles de températures.

Les deux méthodes donnent des résultats très différents ce qui prouve que les séries sont affectées par un biais important qui devrait être expliqué. A défaut d’explication, ces constructions n’ont aucune valeur descriptive. Et, il n’existe aucune explication à ce phénomène qui soit compatible avec ce que ces indices sont censés représenter.

On voit notamment que les intervalles de confiance sont de l’ordre de 1°C pour la fameuse période dite « pré-industrielle ».

Ces marges d’erreurs ne tiennent pas compte des biais, elles donnent donc une image complètement fausse de la fiabilté des indices.

Ces problèmes sont connus et identifiés dans la littératures scientifique depuis au moins 20 ans.

J’aimeAimé par 1 personne

Pour avoir une idée la différence entre les deux méthodes, on peut utiliser par exemple les bases QCU et QCA de GHCN :

C’est une estimation faible de la différence parce que l’ajustement GHCN n’est qu’un étage du processus. Ensuite, cette différence ne permet pas encore de connaître l’évolution réelle, elle révèle juste la présence d’un biais. Ce biais n’est pas expliqué par les climatologues mais n’est pas si difficile à comprendre. Quand vous faites des mesures, il est en général nécessaire de recalibrer l’instrument, surtout quand ces mesures s’étendent sur plus d’un siècle. L’instrument n’est pas tant ici le thermomètre que l’ensemble du système station dont fait partie le thermomètre. On sait très bien que ce système est soumis à une augmentation des perturbations assez régulière du fait des activités humaines proches mais aussi plus éloignées (étanchéification progressive de l’environnement urbanisé, augmentation de l’utilisation d’énergie et donc de la dissipation thermique). L’ordre de grandeur de ces effets est important puisqu’il double à peu près la production de chaleur sensible dans les zones urbanisées. Assez régulièrement, c’est à dire en moyenne tous les 20 ans pour donner un ordre de grandeur, les instruments sont repositionnés sur une plus ou moins grande distance. Statistiquement parlant, ils le sont vers des endroits un peu moins perturbés. Cela peut être vu comme des recalibrages et donne lieu à des baisses brusques de la température mesurée. Les ajustements opérés pour construire les indices consistent ni plus ni moins qu’à supprimer les recalibrages opérés. Vu autrement, cela consiste à ne tenir compte que de l’évolution à court terme, donc à incorporer la totalité du biais anthropique présent dans les séries de températures.

Traiter convenablement les données demanderait donc premièrement de ne pas procéder aux homogénéisation et ensuite de tenir compte du résidu de biais anthropique qui affecte encore les séries de données brutes.

J’aimeJ’aime

Coucou,

Super interessant. Merci.

En ce qui concerne les biais, il y a toujours un chercheur (du giec) qui a cherché et trouvé un algorithme mathematique qui permet de corriger ou pondérer comme vous dites en math.

Des calculs super sophistique pour une liste de températures relativement simple.

Même si la méthode est juste, le biais n’est il pas dans le fait qu’on obtient le résultat que l’on voulait obtenir ?

Bonne journée

Stéphane

J’aimeJ’aime

C’est le biais de confirmation, bien connu dans les expérimentations bio usant des statistiques sur leurs résultats. Il ne peut être combattu que par les expériences en double aveugle. En physique c’est plus compliqué. Comme je le disais plus haut le simple traitement intensif de données héritées de chercheurs passés recueillant religieusement des données (en espérant qu’elles finiront par servir à quelque chose) n’est pas suffisant. Pour faire un grand pas, il faut souvent que la théorie suggère de faire un type de mesures jamais fait avant et pour lequel il faut construire une nouvelle méthode de mesure. On n’avance pas en accumulant des mesures avec un appareil acheté sur catalogue et un logiciel de traitement de données.

J’aimeJ’aime

@Jean-Claude BARESCUT

Bonjour Monsieur.

Je voudrais en premier lieu vous féliciter de vos excellents commentaires au ton mesuré si rare… Pour un béotien comme moi, c’est très productif. En second lieu je souhaite vous interroger sur le point suivant : il est très fréquemment affirmé sur ce site que depuis 20 ans la température ne monte plus (« plateau »), ce que ne semble pas faire apparaître le dernier croquis de cette page.

Avec mes vifs remerciements anticipés

J’aimeJ’aime

Suivant la fenêtre de temps que l’on choisit, on peut trouver des montées ou des baisses. Cela pourrait n’être que des simples fluctuations aléatoires, c’est à dire des fluctuations que l’on observerait même si toutes les causes possibles restaient au même niveau. Il y a sans doute un climat « moyen » correspondant à un jeu des états des causes possibles. Mais comme beaucoup de ces causes sont elle-mêmes affectées de fluctuations (ou de périodicités comme les paramètres astronomiques), il est tout à fait possible qu’il y ait de temps en temps l’équivalent d’une vague scélérate quand plusieurs causes arrivent simultanément en phase. Comme les causes ne sont pas parfaitement connues, il est difficile de savoir si une phase de montée des températures est due à une prépondérance d’un seul phénomène (les émissions de GES en occurrence), ou a une conjonction de phénomènes. Ce que j’exprime de temps en temps dans mes commentaires c’est mon scepticisme devant les performances des modèles atmosphériques. Et mon agacement envers tous ceux qui tentent de surfer sur cette mode pour alimenter des équipes de recherche besogneuses. Je n’ai jamais exprimé de certitudes sur l’existence ou non d’un changement climatique induit par nos émissions de GES. En revanche je n’ai guère de doutes sur la volonté d’instrumentaliser cette question par des forces politiques malsaines. L’empressement à dénoncer nos « mauvais » comportements et à vouloir mettre en place des solutions à base de taxes et de restrictions de libertés est hautement suspect.

J’aimeAimé par 1 personne

On n’en est toujours à se demander si la théorie des gaz à effet de serre se vérifie expérimentalement. Cette question rend la discussion difficile avec ce qui y croient dur comme fer. Il faudrait quand même avoir la réponse…

J’aimeJ’aime

he oui

à chaque occasion, je ne manque pas de rappeler cette curiosité:il n’existe pas de confirmation expérimentale de cette théorie, malgré les sommes colossales déjà « cramées, mais surtout celles qui sont en jeu.

étonnant non?

Spencer a bien tenté avec quelques « expériences » de géotrouvetout , qui visiblement ne servaient qu’à le conforter dans ses convictions.

Comme il ,n’y a pas non plus de consensus, et à fortiori, de confirmation expérimentale de l’éventuelle effet d’une potentielle « back radiation » sur la t° de l’océan

On s’attendrait à ce que ces petites « curiosités » soient résolues en priorité,mais cela ne semble pas déranger les climatologues patentés

Concernant les courbes de t°, celles des océans sont encore plus rigolotes, vous savez l’océan où est stockée l’essentiel de l’énergie reçue du soleil, et où se cache, tapie telle l’harpie prête à bondir la chaleur introuvable des modèles.

J’aimeAimé par 1 personne

Perso, je suis satisfait de voir enfin publiées ici des courbes de données correspondant parfaitement avec ce que j’ai moi même tracé depuis des années en particulier pour plusieurs stations européennes et françaises. Par exemple l’augmentation observée courbe parag 5, est très proche de +2°C pour la France depuis 1900, et pas de 0.4° ou 0.6° comme certains me l’ont affirmé plusieurs fois sur des posts précédents.

Et en plus, on peut noter le gradient décennal qui a nettement augmenté ces dernières décennies. De l’ordre de 0.4°C à 0.45°C par décennie, ce qui cumulé avec les 2° déjà acquis sur l’intervalle 1900-2019, donne bien quelque chose comme +5°C pour 2100, autant que ce qui nous sépare de la dernière période glaciaire !!!

J’aimeJ’aime

Coucou,

Et quand bien même, cela change quoi ?

On ne sait pas comment çà marche.

Donc on ne sait si l’iinfluence de l’homme est décisive ou négligeable.( de mon point de vue sans doute pas plus que les vaches !)

On ne sait pas régler le thermometre. ( et c’est tant mieux)

Alors constater que les glaciers ont fondu dans les Alpes, donc qu’il a moins plu ou que cela s’est réchauffé un peu, çà fait de nouveaux paysages, de nouveaux fromages, et on s’adaptera.

Et on continuera de chercher à comprendre pour se préparer, dans quelques générations(5? 10, 50 ,?) au futur refroidissement Inéluctable .

Vive la recherche,

Bonne soirée

Stéphane

J’aimeAimé par 1 personne

Stéphane

Comment peut on dire qu’un refroidissement est inéluctable ?

On ne sait pas régler le thermomètre, sans doute. Mais on a peut-être déjà réussi à le dérégler non ? S’adapter, c’est probable, mais à quoi ? Jusqu’à quelle limite ? Combien faudra t’il dépenser pour prévenir ou réparer les conséquences de ces changements ? D’année en année, les moyens mis en œuvre grandissent mais paraissent bien dérisoires.

J’aimeJ’aime

Coucou,

Disons qu’il y a une théorie, que j’ai apprise à l’école, avec les périodes glaciaires et interglaciaire. Selon cette théorie, nous vivons dans une période interglaciaire,(une période chaude donc) depuis à peu prés 15 000 ans.

Je n’ai jamais lu que cette theorie est erronée, dépassée, obsolete; donc, probablement il y aura de nouveau une glaciation.

Brrrrrrrrrr

Je vis dans le jura, et je deteste l’idée du froid permanent, immobile .

je préfére l’idée du chaud ! du pas trop chaud, comme on a en France, un vrai pays de cocagne !

Bonne soirée

Stéphane

J’aimeJ’aime

Coucou,

Les apprentis sorciers veulent réparer un truc dont ils n’ont absolument pas la moindre idée de comment cela fonctionne. Et que je t’emploie des mots savants de molière, que je t’empile les concepts , et que je te compile des données, des programmes, des courbes qui montent …

Mais tout cela n’a pas le moindre sens.

La planete est immense , infinie, à l’echelle humaine.

L’homme est tout petit, miniuscule dans le temps et dans l’espace. Tout petit et chetif devant les maladies, la sauvagerie animale , minerale du monde.

Se prendre pour zeus et croire que l’on peut réparer me parait tellement dingue …

L’idée même est tellement saugrenue.

Essayer de preserver le milieu dans lequel on vit, en produisant intelligemment d’accord, mais réparer le climat, cela me fait penser à don quichotte.

Ca veut dire quoi un climat qui fonctionne ? rien,

çà ne veut rien dire , merde !

Désolé, je m’emporte. je soliloque

Bonne soirée

Stéphane

J’aimeAimé par 2 personnes

Non, je suis d’accord.

« Les apprentis sorciers veulent réparer un truc dont ils n’ont absolument pas la moindre idée de comment cela fonctionne. »

Et on ne sait même pas si le « truc » est cassé.

J’aimeJ’aime

Merci MD pour avoir décortiqué « un exemple » comme vous le dites si bien.

Du coup il est une fois encore nécessaire de rappeler que le couple CRU-Hadley n’est pas le seul à officier dans le domaine et que beaucoup d’autres instituts produisent eux aussi leurs courbes de température globale avec des méthodes radicalement différentes et que, fort heureusement, ils se sont intéressés aux biais potentiels bien avant que les CS en ait la moindre idée.

D’un point de vue factuel où en est-on ? Les tendances depuis 1979 (exprimées en °C/siècle) sont les suivantes :

HadCRUT +1.7, NOAAGlobalTemp +1.7, GISTEMP +1.8, Cowtan & Way +1.9, Berkeley Earth +1.9, JRA-55 +1.8, ERA-5 +1.8, RSS +2.0, UAH +1.3

Les estimations sont donc toutes cohérentes, y compris pour les climato-sceptique de Berkeley.

Le truc sympa c’est que les projections faites par Exxon en 1982 concordent très bien avec les évolutions de températures depuis 40 ans : anomalie moyenne de +0.8 pour les instituts ci-dessus ; anomalie de +0.9°C pour Exxon en 2019 ; pente de +2.3°C depuis 1980, toujours pour Exxon.

Si on regarde les tendances 1910-1945 on a (toujours en °C/siècle) :

HadCRUT +1.4, NOAAGlobalTemp +1.5, GISTEMP +1.4, Cowtan & Way +1.5, Berkeley Earth +1.5, c’est-à-dire des pentes plus faibles que les pentes actuelles (20% de moins).

J’aimeJ’aime

Ping : Révisionnisme | Mythes, Mancies & Mathématiques

Ping : BEST of | Mythes, Mancies & Mathématiques